Uncategorized

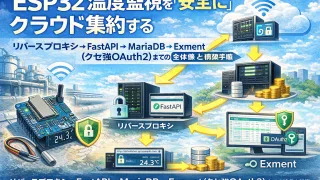

Uncategorized ESP32温度監視を「安全に」クラウド集約する:リバースプロキシ→FastAPI→MariaDB→Exment(クセ強OAuth2)までの全体像と構築手順

工場や現場の温度監視(HACCP・衛生管理)をIoT化しようとすると、 「ESP32で測る」だけでは終わりません。送信経路の安定化、外部公開の安全性、DB設計、そして最終的な帳票・記録システム(Exment等)への連携まで、 意外と“地雷”...

Uncategorized

Uncategorized  Uncategorized

Uncategorized  Uncategorized

Uncategorized  Uncategorized

Uncategorized  Uncategorized

Uncategorized  Uncategorized

Uncategorized  Uncategorized

Uncategorized  Uncategorized

Uncategorized  Uncategorized

Uncategorized  Uncategorized

Uncategorized